Hallo zusammen,

basierend auf verschiedenen Tutorials habe ich mir in Proxmox eine VM erstellt, dort Docker und Paperless installiert. Das funktioniert soweit und ich bin dabei, Dokumente von Devonthink zu Paperless zu migrieren.

Beim Versuche, den nächsten Ordner mit Dokumenten in dem „consume“ Verzeichnis von Paperless abzulegen, erhalte ich aber die Meldung, dass der Speicherplatz nicht ausreicht. Dort hänge ich grade und komme mit meinem beschränkten Wissen nicht weiter.

Hat hier jemand eine Idee, wie ich das Problem weiter identifizieren, oder wo ich wie suchen kann? Ich kann mit den mir bekannten Mitteln grade nicht erkennen, dass der Speicherplatz irgendwo tatsächlich eng ist.

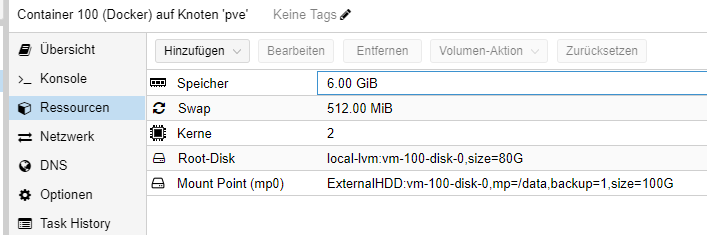

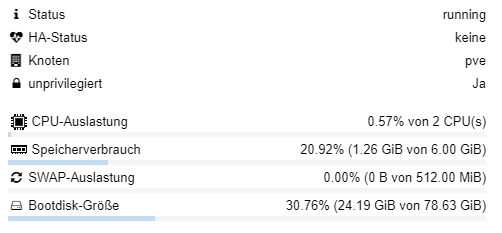

Das hier ist meine VM in Proxmox:

Hier ist die zugehörige docker-compose.yaml

services:

broker:

image: docker.io/library/redis:7

container_name: broker

restart: unless-stopped

volumes:

- /data/paperless/redis/_data:/data

db:

image: docker.io/library/postgres:13

container_name: db

restart: unless-stopped

volumes:

- /data/paperless/postgresql/_data:/var/lib/postgresql/data

environment:

POSTGRES_DB: paperless

POSTGRES_USER: user

POSTGRES_PASSWORD: password

webserver:

image: ghcr.io/paperless-ngx/paperless-ngx:latest

container_name: webserver

restart: unless-stopped

depends_on:

- db

- broker

- gotenberg

- tika

ports:

- 8001:8000

healthcheck:

test: ["CMD", "curl", "-fs", "-S", "--max-time", "2", "http://localhost:8000"]

interval: 30s

timeout: 10s

retries: 5

volumes:

- /data/paperless/consume:/usr/src/paperless/consume

- /data/paperless/data:/usr/src/paperless/data

- /data/paperless/media:/usr/src/paperless/media

- /data/paperless/export:/usr/src/paperless/export

- ./scripts:/scripts:ro

environment:

PAPERLESS_FILENAME_FORMAT: "{correspondent}/{created_year}/{created} {title}"

PAPERLESS_CONSUMER_RECURSIVE: 1

PAPERLESS_CONSUMER_SUBDIRS_AS_TAGS: true

PAPERLESS_FILENAME_DATE_ORDER: YMD

# PAPERLESS_CONSUMER_IGNORE_PATTERNS: [".DS_Store", ".DS_STORE", "._*", ".stfolder/*", ".stversions/*", ".localized/*", "desktop.ini", "@eaDir/*", "Thumbs.db"]

PAPERLESS_ADMIN_USER: paperless

PAPERLESS_ADMIN_PASSWORD: paperless

PAPERLESS_REDIS: redis://broker:6379

PAPERLESS_DBHOST: db

PAPERLESS_TIKA_ENABLED: 1

PAPERLESS_TIKA_GOTENBERG_ENDPOINT: http://gotenberg:3000

PAPERLESS_TIKA_ENDPOINT: http://tika:9998

PAPERLESS_OCR_LANGUAGE: deu

PAPERLESS_OCR_USER_ARGS: '{"invalidate_digital_signatures": true}'

PAPERLESS_TIME_ZONE: Europe/Berlin

PAPERLESS_PRE_CONSUME_SCRIPT: /scripts/pre-consume.sh

USERMAP_UID: 1002

USERMAP_GID: 1002

PAPERLESS_DATE_ORDER: DMY

PAPERLESS_IGNORE_DATES: 27.12.2018,23.09.1981,07.12.1981

gotenberg:

image: docker.io/gotenberg/gotenberg:8.8.0

container_name: gotemberg

restart: unless-stopped

command:

- "gotenberg"

- "--chromium-disable-routes=true"

- "--chromium-allow-list=file:///tmp/.*"

tika:

image: ghcr.io/paperless-ngx/tika:latest

container_name: tika

restart: unless-stopped

So sieht der Eintrag in meiner smb.conf für den Zugriff auf das Verzeichnis aus:

[paperless]

comment = Paperless SMB Share

valid users = paperless

path = /data/paperless/

public = no

writable = yes

printable = no

browsable = no

guest ok = no

create mask = 0700

directory mask = 0700

Ausgabe von df

root@Docker:/etc/samba# df

Dateisystem 1K-Blöcke Benutzt Verfügbar Verw% Eingehängt auf

/dev/mapper/pve-vm--100--disk--0 82447192 25363184 53309588 33% /

/dev/mapper/ExternalHDD-vm--100--disk--0 103085644 2276972 95549408 3% /data

none 492 4 488 1% /dev

udev 8096680 365760 7730920 5% /dev/tty

tmpfs 8130468 0 8130468 0% /dev/shm

tmpfs 3252188 2584 3249604 1% /run

tmpfs 5120 0 5120 0% /run/lock

overlay 82447192 25363184 53309588 33% /var/lib/docker/overlay2/52fe4c32027612c719ff7ef5f723fab29a943c7638229089a24e6dea98a4aa64/merged

overlay 82447192 25363184 53309588 33% /var/lib/docker/overlay2/e3ccad7f041055734929ce4bccdbea610a7e448d53ff971eae0273998c8bf2dd/merged

overlay 82447192 25363184 53309588 33% /var/lib/docker/overlay2/2ae93603869da2509b67bd5ef09e3a9b81a3285c633a3c9afc477767dbc935f4/merged

overlay 82447192 25363184 53309588 33% /var/lib/docker/overlay2/ed92b15d8a01e8ba55115e064ea6b24a8f04b2848aee80c79d406a0d3245e4ce/merged

overlay 82447192 25363184 53309588 33% /var/lib/docker/overlay2/c185102d2431a2ae4000db286269f98d3b3a497c42fa261dc5c9e31580e98f69/merged

overlay 82447192 25363184 53309588 33% /var/lib/docker/overlay2/597513d7db3c78f6e022bf197fff9c07b5588bb458e9043a860b70a31202bb90/merged

overlay

Ich danke für die Hilfe und hoffe, dass diese Frage grundsätzlich hier in Ordnung ist.